"Aujourd'hui, on a la capacité de faire une interaction intelligente pour de vrai" : les deepfakes audio de plus en plus difficiles à détecter

L'intelligence artificielle générative a ouvert une nouvelle ère de désinformation avec la prolifération de deepfakes, et notamment des voix clonées. S'il est difficile de détecter le vrai du faux simplement à l'oreille, comment savoir les repérer ?

/2024/02/21/img67698-comprescarre-65d5d5ce2b7cf433086189.png)

/2025/04/04/gettyimages-1997666795-67efd087efce4766706428.jpg)

Vous êtes-vous déjà fait duper par une voix, qui ressemblait étrangement à celle d’une personne, mais qui finalement n’était pas réelle ? Le phénomène des deepfakes n'est pas nouveau : le premier deepfake "grand public", en 2018, mettait en scène l'ancien président américain Barack Obama insultant Donald Trump. Une vidéo vue des millions de fois et qui mettait en lumière le phénomène.

Depuis, des campagnes de désinformation à grande échelle utilisent l'intelligence artificielle pour tromper les internautes, comme cette fausse allocution du président ukrainien Volodymyr Zelensky annonçant sa défaite face à l’armée russe. En septembre 2024, un deepfake de l'ancien Premier ministre Michel Barnier était devenu lui aussi viral sur les réseaux sociaux, et beaucoup d'internautes y avaient cru.

Un arsenal qui les rend "cruellement efficaces"

Les deepfakes vidéo peuvent être plus facilement détectables, mais qu'en est-il des deepfakes audio ? Pour en générer il ne suffit que de quelques secondes d'enregistrement pour créer un clone grâce à divers logiciels d'IA générative, comme ElevenLabs, où l'internaute peut choisir l'intonation, la vitesse d'élocution, les tics de langage. "Ces contenus jouent avec nos émotions, nous emmènent dans le domaine de la réaction plutôt que la réflexion, que ce soit la surprise, l'humour, le choc, explique Camille Salinesi, professeur en informatique, co-responsable de l'Observatoire de l'IA à l’Université Paris 1 Panthéon-Sorbonne. On est dans un espace qui nous empêche de réfléchir et de nous interroger sur le contenu, sur la raison pour laquelle ce contenu nous arrive, à qui il bénéficie, etc."

Mais si cela fonctionne aussi bien, ce n'est pas seulement grâce à la technologie de production de fakes, car cette technologie se retrouve "combinée avec des algorithmes de recommandation, avec des technologies de personnalisation, poursuit le spécialiste. On utilise aussi des technologies d'IA qui vont permettre de s'assurer que c'est le bon contenu qui arrive à la bonne personne par des techniques de microciblage. C'est tout cet arsenal d'intelligence artificielle qui rend finalement les deepfakes cruellement efficaces."

Détecter les deepfakes grâce à l'intelligence artificielle ?

S'il est difficile de détecter le vrai du faux simplement à l'oreille, il existe aujourd'hui des logiciels d'intelligence artificielle qui peuvent le faire à notre place. C'est d'ailleurs le cas de logiciels existants comme Sensity AI. Mais ils atteignent aussi leurs limites. "Le problème, c'est que meilleurs sont les détecteurs, meilleurs sont les IA génératives, met en garde Camille Salinesi, car le principe de la création des IA génératives, c'est que ce sont les détecteurs qui les entraînent."

"Une intelligence artificielle générative qui crée des contenus pas parfaitement difficiles à détecter continuera de s'entraîner, jusqu'à ce que les détecteurs ne sachent plus faire la différence entre un contenu réel et un contenu factice."

Camille Salinesi, co-responsable de l'Observatoire de l'IA à l’Université Paris 1 Panthéon-Sorbonneà franceinfo

Il existe aujourd'hui des entreprises qui utilisent des assistants vocaux pour répondre au téléphone, gérer des réservations ou bien donner des renseignements. Pour cela, des éditeurs de robots conversationnels proposent leurs services à leurs clients. "Aujourd'hui on a la capacité de faire une interaction intelligente pour de vrai, explique Katya Lainé, directrice de l'entreprise TalkR. Après, il faut être conscient que même si nous allons mettre des procédés en place pour dire au public que c'est un assistant virtuel avec lequel il interagit, il y a des personnes qui ne le feront pas."

Il faut donc informer et sensibiliser le public sur ces usages problématiques de l'intelligence artificielle à des fins de manipulation, que ce soit pour les désinformer ou même les escroquer.

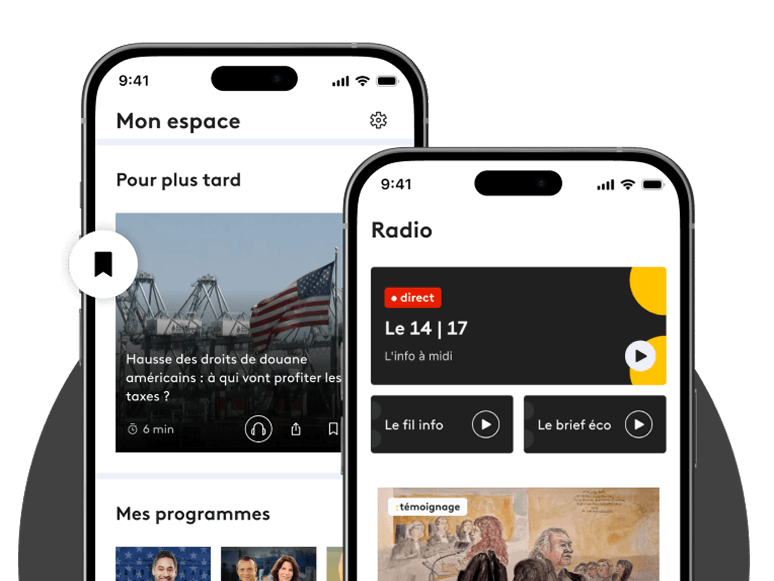

Retrouvez "Les voies de l'IA", un podcast original franceinfo en partenariat avec l'Observatoire de l'intelligence artificielle de l'université Paris 1 Panthéon-Sorbonne et Sorbonne TV, sur le site de franceinfo, l'application Radio France, Sorbonne TV, et plusieurs autres plateformes comme Apple podcasts, Podcast Addict, Spotify, ou Deezer.

À regarder

-

Retour de S. Lecornu : peut-il tenir ?

-

"Je ne l'ai pas tuée" : Cédric Jubillar réaffirme son innocence

-

Oeufs, à consommer sans modération ?

-

Ours : ils attaquent même dans les villes

-

Ce radar surveille le ciel français

-

On a enfin réussi à observer un électron !

-

"Manifestation des diplômés chômeurs, un concept marocain !"

-

Crise politique : "La dernière solution, c'est la démission du président de la République"

-

Le loup fait taire la Fête de la science

-

Les tentatives de suic*de en hausse chez les adolescentes

-

Défi chips : alerte dans un collège

-

Quand tu récupères ton tel à la fin des cours

-

Ukraine : le traumatisme dans la peau

-

Teddy Riner s'engage pour sensibiliser sur la santé mentale

-

Suspension de la réforme des retraites : les gagnants et les perdants

-

Ukraine : le traumatisme dans la peau

-

L'espoir renaît à Gaza après l'accord de cessez-le-feu

-

Une école pour se soigner et réussir

-

Taux immobiliers : est-ce le moment d'acheter ?

-

La panthéonisation de Robert Badinter

-

Cancer : des patientes de plus en plus jeunes

-

"Le Bétharram breton" : 3 établissements catholiques dénoncés par d'anciens élèves

-

Cessez-le-feu à Gaza : un premier pas vers la paix

-

Quand t'as cours au milieu des arbres

-

Il gravit la tour Eiffel en VTT et en 12 min

-

Pourquoi on parle de Robert Badinter aujourd'hui ?

-

Robert Badinter : une vie de combats

-

La tombe de Robert Badinter profanée à Bagneux

-

Accord Hamas-Israël, la joie et l’espoir

-

"Qu’on rende universelle l'abolition de la peine de mort !"

/https%3A%2F%2Fapi.radiofrance.fr%2Fv1%2Fservices%2Fembed%2Fimage%2Fe13f2a99-c518-41e6-875f-68fe95081ff7%3Fpreset%3D400x400)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fde%2F25%2F41%2Fdd1fcb63-a364-4e05-a7ab-dee44a970892.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F4f%2F10%2F5a%2Fda5fe1a8-79af-4afb-bba2-a8580f309cdd.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fec%2Fe7%2Ffe%2Fd0a895fa-5e2d-4cf4-ab8a-f8541487837e.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fe2%2Fe5%2F2f%2Ff6c87632-d6dd-4fde-899d-be4921984d13.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F41%2F12%2Fe3%2Fc215648c-c76e-48e0-9b3f-c536118fb9bd.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fbe%2Fcd%2F58%2F3a453c3c-7a7d-43ab-aad5-536fb54124ef.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F6d%2F08%2Fad%2F4a758417-a9a4-4d6f-b145-08c6c1f4cf2c.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F45%2Fc1%2Ff0%2Fb4aea101-60b5-4ef7-b7c7-1e7f2baa0d88.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F43%2Fac%2F9a%2F0171d094-8fe6-4b15-bf1e-1f91abb64326.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fb7%2Fa5%2Ffe%2Fce1ec1fb-4e93-4341-94f4-3045ab9a59fe.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fa0%2Fc8%2F51%2F2bd11c9a-ea57-4f87-a4ab-644c8c6cf0bd.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F2c%2Fa6%2F94%2F97c1c2c6-ce23-40e4-8bba-3dce55eeb539.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F48%2F1a%2Fa2%2F6bd5eab0-5e00-4555-88c9-c08939e62791.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fc6%2Fb7%2Ff3%2F67fd8d76-05ea-420b-ac58-6dad3c51c4ee.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fa9%2F83%2F9d%2F7f2b0035-b160-454a-8433-324b864b0918.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F8f%2F59%2F9a%2F3becd8ee-d56a-4e6b-98ac-26fa91b44c45.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F43%2Fa8%2F60%2Ff4e583bf-8308-42a8-8ab6-5bcd831eaf36.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F8f%2F96%2F9c%2Fbaf20409-5353-4b89-925b-631f3a10904e.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Faa%2F0b%2F70%2F832b64c4-bd21-42b9-8e05-779a8abc6299.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fc2%2Ff2%2F1a%2F08995e0b-2009-48b4-8746-8309cec69e36.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fcf%2F22%2F70%2F6ff264a7-7864-4826-8297-70f692a49f19.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F4b%2F0e%2F6d%2F29f074bf-d0f0-4a29-aecd-42677479181c.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F94%2Fa2%2Ff7%2F66708f9d-5693-4cbd-93cb-ef8085ed6adc.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F46%2Fa6%2F00%2F609b8fee-76b2-4961-b0d7-c34343ddb8d6.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F9a%2F82%2Fa7%2Fcae8e340-d76e-4a87-bf64-a71b835d8950.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Ff9%2F75%2Fe5%2Ff6429b61-25ea-4e2d-8a0b-8d1404b69c65.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2Fec%2F71%2Fd5%2F8634e647-e178-47be-a944-547a64d48ebe.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F16%2Fb7%2F8a%2F39a82886-cf41-47d9-9124-c789c626a8bc.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F0f%2F6a%2Fb0%2F7f44ac6e-8398-4d80-8f28-990aa5e74886.jpg)

/https%3A%2F%2Fassets.webservices.francetelevisions.fr%2Fv1%2Fassets%2Fimages%2F39%2F13%2Fdc%2Fef703d43-3a76-47d6-9a44-6af0dce3ae08.jpg)

Commentaires

Connectez-vous ou créez votre espace franceinfo pour commenter.

Déjà un compte ? Se connecter